小优智能科技有限公司成立于2015年底,是一家专注于高精度3D机器视觉模组研发、生产及销售的高科技企业。

公司自主研发的3D机器视觉模组采用激光/DLP白光编码光栅结构光+双工业相机方案,还原物体三维信息,广泛应用于消费电子领域、工业领域和安防领域,具有精度高、速度快、成本低的优势。

浅谈TensorRT加速原理

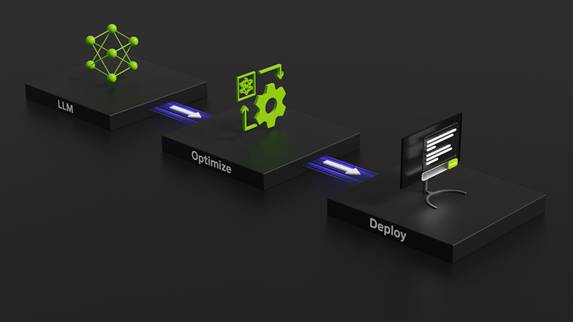

英伟达TensorRT是一种专门为深度学习推理优化的库,它充分利用GPU的并行计算能力,加速神经网络模型的推断过程。基于 NVIDIA TensorRT 的应用程序在推理过程中的执行速度比纯 CPU 平台快达 36 倍,能够优化在所有主要框架上训练的神经网络模型,以高精度校准较低精度,并部署到超大规模数据中心、嵌入式平台或汽车产品平台。在时下流行的LLM大模型推理加速中,NVIDIA TensorRT-LLM开源库更是大放异彩。TensorRT-LLM 加速了用于生成 AI的最新大型语言模型,性能提高了 8 倍,TCO 降低了 5.3 倍,能耗降低了近 6 倍。目前TenorRT框架已经成为在英伟达GPU上部署深度学习模型的不二之选。下面我们将从几个主要方面浅谈TensorRT框架推理加速的原理。

注:图片来自英伟达TensorRT SDK官网 https://developer.nvidia.com/tensorrt

一、精度校准:

1. FP16量化:

FP16(半精度浮点数)是指使用16位二进制表示浮点数,相较于传统的32位浮点数,占用更少的存储空间,并能够在GPU上进行更高效的运算。TensorRT支持将模型的权重和激活函数的精度从FP32减少到FP16,从而减小了内存占用和计算复杂度。FP16量化在深度学习推理中通常能够保持良好的模型准确性,特别是对于计算资源有限的嵌入式设备或移动平台而言。

2. INT8量化:

INT8(8位整数)量化更进一步地减小了模型的存储需求和计算开销。在INT8量化中,模型参数和激活值都被量化为8位整数,从而显著减小了内存占用和运算开销。为了将浮点数量化为整数,通常需要通过离散化的方法,例如乘以一个缩放因子并进行四舍五入。虽然INT8量化引入了量化误差,但在许多实际应用中,可以通过合适的校准和训练来保持模型的高精度。

3. TensorRT支持的精度校准方法:

TensorRT提供了几种方法来进行精度校准,以满足不同的应用需求:

1)统一精度校准(Unified Precision Calibration): TensorRT使用统一的方法将FP32模型量化到FP16或INT8,适用于大多数深度学习模型。

2)自定义精度校准(Custom Calibration): 允许用户自定义量化过程,以便更好地适应特定模型结构和需求。

3)在线精度校准(Online Calibration): 允许在模型推断过程中进行在线校准,动态适应模型的输入数据分布。

这些方法使得开发者能够根据应用场景的不同选择合适的精度校准策略,权衡模型精度和推理性能。

通过使用TensorRT的精度校准功能,开发者可以灵活地选择适合其应用场景的量化方法,在提高推理速度的同时,最大限度地保持模型的准确性。这对于在嵌入式系统、移动设备等资源有限的环境中进行深度学习推理非常重要。

二、层融合:

层融合是通过将多个网络层组合成一个更大的层,以减小计算负担,提高推理性能的技术。层融合在TensorRT中通过一系列优化技术和规则实现,下面详细描述一下TensorRT中的层融合过程:

层融合的具体过程:

规则定义: TensorRT使用一系列规则来确定哪些层可以被融合以及如何融合。这些规则考虑了网络的拓扑结构和支持的操作。例如,卷积层和激活函数(如ReLU)常常可以被融合在一起,以减少内存访问和计算负担。

融合操作的选择: 一旦确定了可以融合的层,TensorRT会选择合适的操作将它们融合在一起。例如,对于卷积层和激活函数的融合,可以将它们组合成一个新的操作,称为卷积-激活(Convolution-ReLU)操作。这样做的好处是避免了在两个层之间传递数据的需要,减少了内存开销。

融合参数的调整: 在层融合的过程中,TensorRT可能会调整融合操作的参数,以保持模型的准确性。例如,它可能会调整激活函数的阈值,以适应新的融合操作。

重复应用规则: 层融合是一个迭代的过程,TensorRT会多次应用规则,尝试找到最优的融合策略。这样可以确保在最大程度上减小计算负担的同时,保持模型的准确性。

三、多流执行:

英伟达TensorRT具备用于并行处理多个输入流的可扩展设计的能力,这种能力使得在实际应用中能够高效地处理多个输入数据流,适用于实时、多通道、或者批处理的场景。以下是TensorRT在多输入流处理方面的详细描述:

多输入流处理的可扩展设计:

多流插槽(Multistream Slots): TensorRT引入了多流插槽的概念,允许在单个TensorRT引擎中并行处理多个输入流。每个流插槽都关联着一个输入流,使得多个输入数据流能够独立地传递到TensorRT引擎中。

图优化的并行处理: TensorRT对图进行优化时,会考虑多个输入流的并行性。这包括层融合、算法选择等优化步骤,确保每个输入流都能够充分利用GPU的并行计算能力。

动态扩展性: TensorRT的设计考虑到了动态扩展性,允许在运行时动态添加或删除流插槽。这使得在应对不同数量输入流的情况下能够灵活地调整系统设计,适应实时场景或批处理需求。

Batch大小和流的关联: TensorRT支持在图的优化和推理过程中将Batch大小与流插槽关联起来。这样,不同输入流的Batch大小可以是独立的,满足实际应用中不同流的数据分布。

GPU资源管理: TensorRT在处理多个输入流时,能够有效管理GPU资源。通过合理地分配GPU资源,TensorRT可以使不同输入流的推理过程相互独立,充分利用GPU的计算能力。

四、内核自动调整:

英伟达TensorRT可以基于目标 GPU 平台选择最佳数据层和算法,具体实现方法如下:

硬件特性识别: TensorRT能够识别目标GPU平台的硬件特性,包括CUDA架构、CUDA核心数量、存储器带宽等。这使得TensorRT能够充分利用目标硬件的并行计算能力,选择适合该硬件的算法和数据层。

算法选择: TensorRT通过优化和选择适当的算法,以最大限度地发挥目标GPU的性能。这包括选择高效的卷积实现、优化的矩阵运算等。TensorRT根据目标GPU的架构和性能特点,选择在该硬件上执行最佳的深度学习算法。

数据层选择: 不同的GPU架构对于数据的访问模式有不同的要求,包括存储器带宽、缓存大小等。TensorRT可以根据目标GPU的特性选择最佳的数据层,以优化内存访问模式,提高数据的加载和传递效率。

精确的性能模型: TensorRT利用对GPU硬件的深入了解,建立了精确的性能模型。这使得在模型推理前,TensorRT能够预测不同部分的计算时间,并基于这些预测进行一系列的优化,包括层融合、精度校准等,以提高整体推理性能。

通过这些能力,TensorRT能够实现对目标GPU平台的智能适配,充分发挥硬件的性能潜力,提供高效的深度学习推理。这对于在不同硬件环境中部署深度学习模型,实现最佳性能至关重要。

五、动态张量显存:

动态张量内存技术通常指的是在运行时动态分配和管理张量(Tensor)内存的能力。这种技术对于处理变长序列、动态形状(Dynamic Shapes)或者在推理过程中动态修改模型结构的情况非常有用。

动态分配和释放内存: TensorRT可能具有在运行时根据实际需要动态分配和释放张量内存的能力。这对于不同批次大小或输入形状的情况非常有用。

支持变长序列: 对于处理变长序列的任务,例如自然语言处理中的自然语言理解(NLU),动态张量内存技术可以使得模型能够适应不同长度的输入序列。

TensorRT运行时引擎: TensorRT的运行时引擎包括一些智能的内存管理机制,以便更灵活地处理动态张量。这可能涉及到内存池管理、动态内存分配算法等。

注:图片来自英伟达TensorRT官网介绍https://developer.nvidia.cn/tensorrt

总体而言,TensorRT的加速原理是通过一系列优化技术和并行计算来最大程度地提高深度学习推理的速度。这些技术包括精度校准、层融合、多流执行、内核自动调整及动态张量显存。通过使用TensorRT,开发者可以在保持模型准确性的同时,显著提高推理性能,从而更好地满足实时和高效的深度学习应用需求。

如有侵权,联系删除。